Американский Центр стратегических и международных исследований (CSIS) недавно опубликовал обращенный к администрации Трампа доклад под названием Opportunities to Strengthen U.S. Biosecurity from AI-Enabled Bioterrorism: What Policymakers Should Know («Возможности усиления биобезопасности США в условиях биотерроризма с использованием искусственного интеллекта: что должны знать политики»), в котором звучит призыв к разработке новых видов биологического оружия при помощи продвинутых американских моделей искусственного интеллекта.

По понятным причинам авторы доклада напрямую такой призыв не озвучивают.

Он просто приводят десятки примеров ужасающих их возможностей «больших языковых моделей» (LLM). Известных в просторечии как чат-боты в разработке новых видов биололгич6еского оружия.

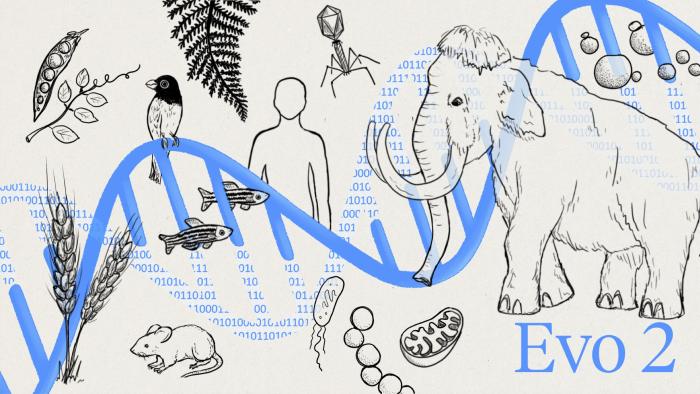

Так, чат-бот Evo 2, разработанный компанией Arc Institute (Пало Альто, Калифорния), в сотрудничестве с ведущим американским разработчиком чипов NVIDIA разработал «крупнейшую на сегодняшний день модель искусственного интеллекта для биологии, объединяя исследователей из Стэнфордского университета, Калифорнийского университета в Беркли и Калифорнийского университета в Сан-Франциско».

«Evo 2 обучен на ДНК более чем 100 000 видов со всего древа жизни. Глубокое понимание биологического кода позволяет Evo 2 выявлять закономерности в последовательностях генов у различных организмов, на обнаружение которых экспериментальным исследователям потребовались бы годы. Модель может точно определять мутации, вызывающие заболевания в генах человека, и способна создавать новые геномы, длина которых сравнима с длиной геномов простых бактерий… В дополнение к расширенной коллекции геномов бактерий, архей и фагов Evo 2 включает информацию о людях, растениях и других одноклеточных и многоклеточных видах эукариотической области жизни», – сообщают эксперты Arc Institute.

Нетрудно догадаться, что этому чат-боту сообщили генетические данные населения стран, где расположены военные биолаборатории Пентагона.

Авторы доклада CSIS далее ссылаются на статью от 5 марта 2025 года, опубликованную бывшим генеральным директором Google Эриком Шмидтом, бывшим генеральным директором Scale AI Александром Ваном и исполнительным директором Центра безопасности ИИ Дэном Хендриксом, в которой утверждается, что «искусственный интеллект может предоставлять пошаговые инструкции по разработке смертельно опасных патогенов, поиску материалов и оптимизации методов распространения. То, что раньше требовало специальных знаний и ресурсов, может стать доступным для лиц со злыми намерениями, что значительно увеличит вероятность катастрофических последствий».

Видимо, авторы статьи были знакомы с возможностями чат-бота Evo 2.

Дарио Амодей, генеральный директор лаборатории ИИ Anthropic, предсказал еще в 2023 году, что такие возможности могут стать реальностью уже через два-три года. Компания Anthropic недавно сообщила о результатах испытаний, показавших, что одна из ее последних моделей, Claude 3.7 Sonnet, уже «демонстрирует тревожные улучшения в своей способности поддерживать аспекты разработки биологического оружия».

Оценка модели Claude 3.7 Sonnet, проведенная Anthropic, также показала, что модель «предоставляет более качественные рекомендации на ключевых этапах пути создания оружия, совершает меньше ошибок на критических этапах… и в конечном итоге ускоряет решение сложных проблем в создании оружия массового уничтожения» по сравнению с предыдущими моделями.

Странный подход у американских разработчиков ИИ: сначала учат свои чат-боты разрабатывать биологическое оружие, а затем тревожатся по этому поводу, причем выражается это весьма своеобразно – в создании еще более продвинутых чат-ботов, специализированных в создании биооружия.

Так, например, поступили в компании Anthropic, создав новую модель, Claude Opus 4, которая демонстрирует «более точные и полные ответы в некоторых областях, связанных с биологическим оружием», по сравнению с Claude 3.7».

В феврале 2025 года компания Илона Маска и Сэма Альтмана OpenAI опубликовала оценку безопасности одной из своих самых продвинутых ИИ-моделей Deep Research, в которой заявила: «Наши оценки показали, что Deep Research может помочь экспертам в оперативном планировании воспроизведения известной биологической угрозы… это указывают на то, что наши модели находятся на пороге того, чтобы оказать существенную помощь новичкам в создании известных биологических угроз».

Авторы доклада CSIS призывают администрацию Трампа умножить усилия по «обеспечению биобезопасности как важнейшего императива национальной безопасности в эпоху ИИ», фактически имея в виду увеличение бюджетной поддержки разработок генетических программ двойного назначения с помощью ИИ.

Практически одновременно с публикацией доклада CSIS американский «Совет по стратегическим рискам» (CSR), финансируемый прогрессивным миллиардером Дастином Московицем, объявил о начале «приема заявок в рамках стипендиальной программы по борьбе с биологическим оружием».

Актуальность этой борьбы мотивируется не в последнюю очередь тем, что, как пишут авторы доклада CSIS, «двойное назначение биотехнологий, основанных на ИИ, создает новые проблемы безопасности для политиков во всем мире. За почти столетие стоимость и технические знания, необходимые для разработки биологического оружия, резко снизились. Сейчас же стремительное развитие возможностей искусственного интеллекта создает угрозы биобезопасности, в решении которых ИИ может помочь участникам процесса разработки биологического оружия».

В докладе отмечают, что в американские ИИ-модели закладываются ограничения на разработку биологического оружия, но это запреты могут быть легко сняты злоумышленниками.

«США на протяжении четырех десятилетий пытались помешать Конвенции о биологическом оружии создать механизм контроля. Из 182 стран, подписавших конвенцию, США – единственная, которая вышла из переговоров о таком механизме в 2001 году. Очевидно, что, поступая таким образом, США хотят защитить секреты своих 336 биологических лабораторий по всему миру», – пишет Global China Daily.

Нет сомнения, что разработки смертельных патогенов в расположенных по всему миру сотнях военных биолабораториях Пентагона будут ускорены и усовершенствованы с помощью ИИ-моделей компаний Anthropic и OpenAI.

Озвученные экспертами CSIS опасения по поводу возможного использования злоумышленниками этих разработок призваны просто перевести стрелки с подлинных творцов биологического апокалипсиса на ту или иную ложную мишень.